Un siècle d'histoire des systèmes d'information 2000-2010

Epilogue

Retour au sommaire . Retour à l'accueil Dernière révision le 14/10/2021

2000-2010. Invariants et projections

Ouf, l'an 2000 est passé. Mais le monde devient tellement différent que le regard en arrière n'a peut-être plus aucune utilité, aucun sens. J'ai fait le pari contraire. Quand un avion s'enfonce dans la nuit, les nuages et les turbulences, c'est le bon calage de son navigateur gyroscopique qui garantit le maintient de son cap. En fondant au Club de l'hypersomnie un groupe de travail "histoire quantitative de l'informatique", nous espérons précisément dégager des modèles, mathématiques si possibles, pour aider à cette navigation vers des univers nouveux. Des univers qui ne sont même plus des zones blanches, des terrae incognitae sur les planisphères, mais des univers où la carte ne se distingue plus du territoire, où nous construisons ensemble les nouveaux espaces et les représentations que nous nous donnons.

Alors, avec toute la confiance et la prudence que nous inspirent les grands modèles de Verne, Birkenhead ou Nora-Minc, tentons de dégager du siècle passé quelques invariants et quelques axes majeurs d'interrogation.

Commençons par quelques images :

. nos enfants et petits-enfants debout sur un clavier d'ordinateur, à l'aise dans leurs Nike et dans leur écran tactile.

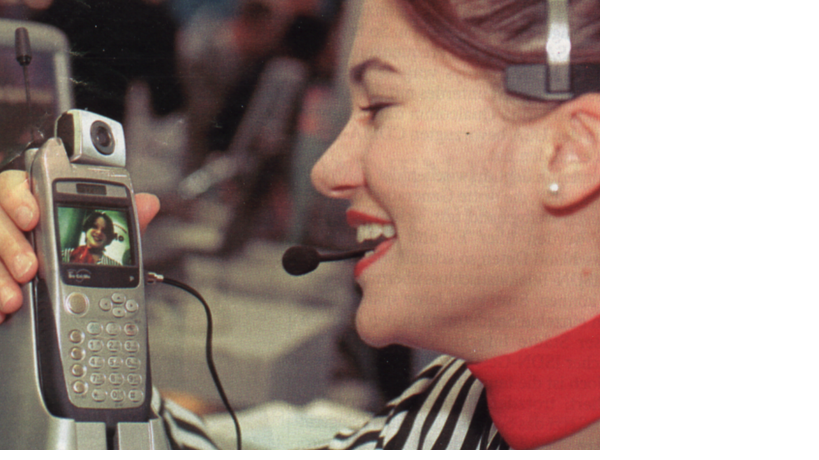

. La visio-conférence banalisée et portative

Sympa. Mais aussi :

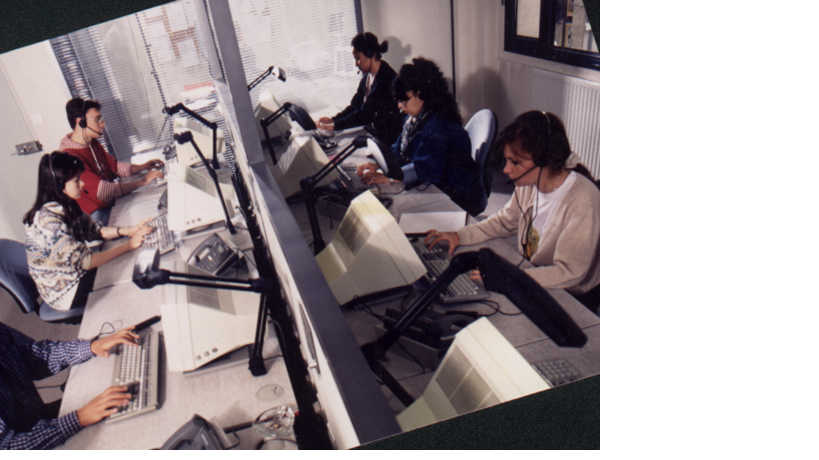

. les jeunes travaillant entassés dans des centres d'appel sous surveillance constante. Quatre secondes maximum entre deux appels successifs. Interdiction de se lever pour aller boire. Celui qui a soif lève la main et on lui apporte une boisson. Evaluation régulière par "appels surprise".

. le soldat de l'an 2000, avec projection d'information devant un œil, fusil auto-stabilisé, treillis tapissé de câbles et de chips

. la nature totalement sous contrôle et digitalisée,

. des espaces digitaux où tous nos fantasmes sont permis sinon encouragés

. et finalement, un monde qui n'a plus besoin de nous, sinon pour la frime quand il a vraiment besoin de consommateurs...

Mais écoutons nos enfants eux-mêmes. Quand j'ai demandé à l'aîné de mes petits fils, cinq ans et demi, et la firme métaphysique comme son grand-père, comment il voyait l'ordinateur. J'espérais qu'il ferait une projection onirique qui vous régalerait. Pas du tout ! Il a tout simplement dessiné SON ordinateur, avec son écran, son clavier, sa souris. Et même sa marque (il ne sait pas lire, il l'a copiée telle quelle). Pour lui, l'ordinateur est un objet de consommation courante. Qu'il compare à celui de papa (il va plus vite pour les jeux). Qu'on trouve aussi chez Papi Pierre. En revanche, Papi Michel n'en a pas (mais lui, il a un bateau).

Restons-donc concrets. En partant de la technique, car il est plus hasardeux de faire des hypothèses à terme sur les désirs des consommateurs et les fantasmes plus ou moins conquérants, pervers ou vertueux, des capitaines d'industrie.

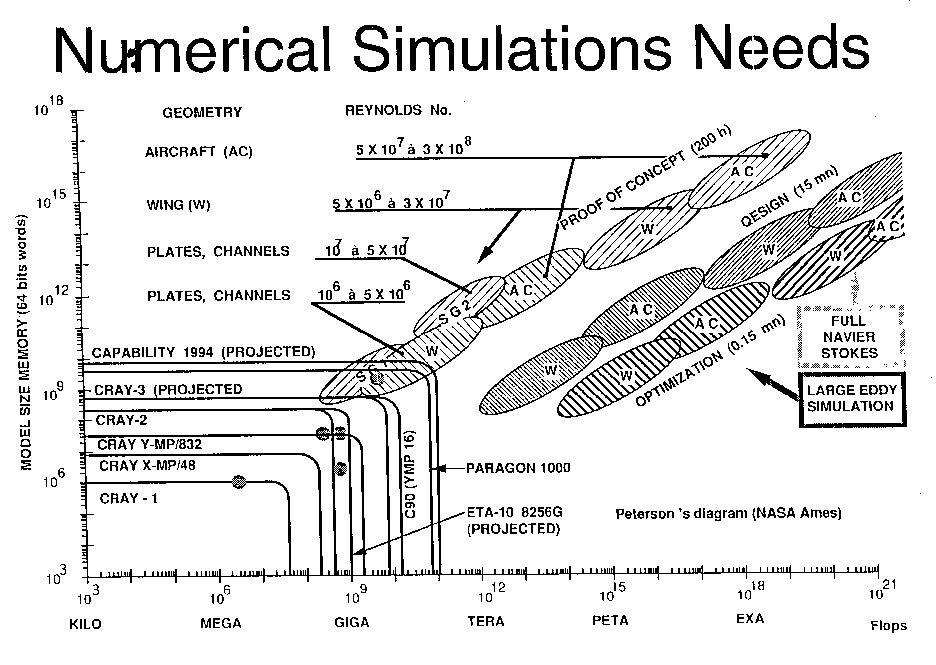

La puissance, jusqu'où ?

La loi de Moore se vérifie depuis trente ans. On peut conjecturer qu'elle est un cas particulier d'une loi plus générale, qui s'appliquerait, mutatis mutandis, à la mécanique, à l'optique... aux objets de silex de la préhistoire (exponentielle de Leroi-Gourhan).

Cette loi, considérée comme une exponentielle avec doublement tous les deux ans, tend à s'accélérer, allant vers un doublement tous les dix huit mois. Il n'y a pas lieu de penser qu'elle se ralentira dans un proche avenir. On n'attent pas non plus de saut technologique qui la remette sérieusement en cause. Des puces à l'échelle moléculaire, pas avant dix ans (Alberganti LM 18-19/7/1999). Les systèmes biologiques ou combinés ? Peut-être. Opérationnels pour le systèmes d'information à quelle échéance ?

Si l'on s'en tient donc à la loi de Moore, , cela nous promet en gros une multiplication de puissance, toutes choses égales par ailleurs, de 100 d'ici à 2010. C'est beaucoup, mais nous n'aurons pas trop de mal à consommer cette puissance. Le multimédia est très gourmand, a fortiori les applications "intelligentes". Le logiciel est un gaz, dit Myrhwold (collaborateur de Bill Gates), il occupe tout l'espace qu'on lui donne.

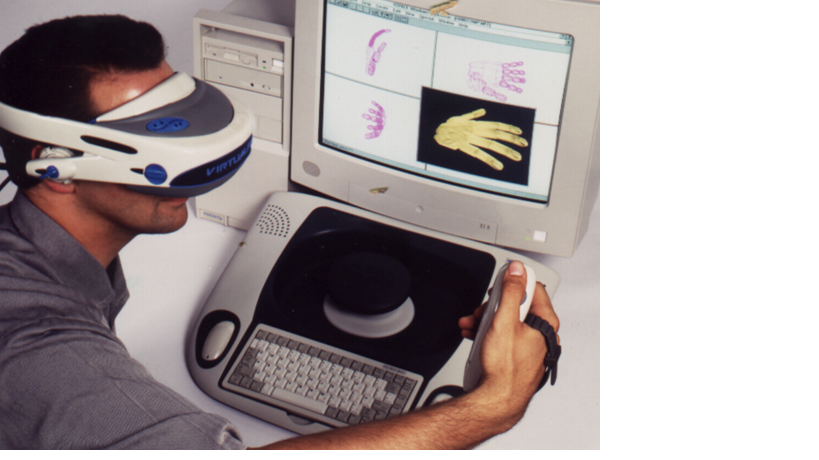

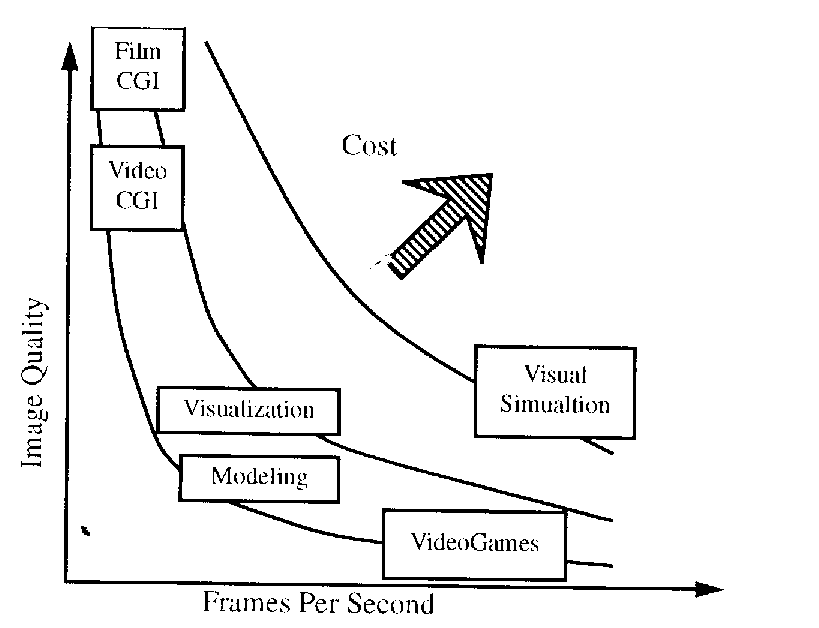

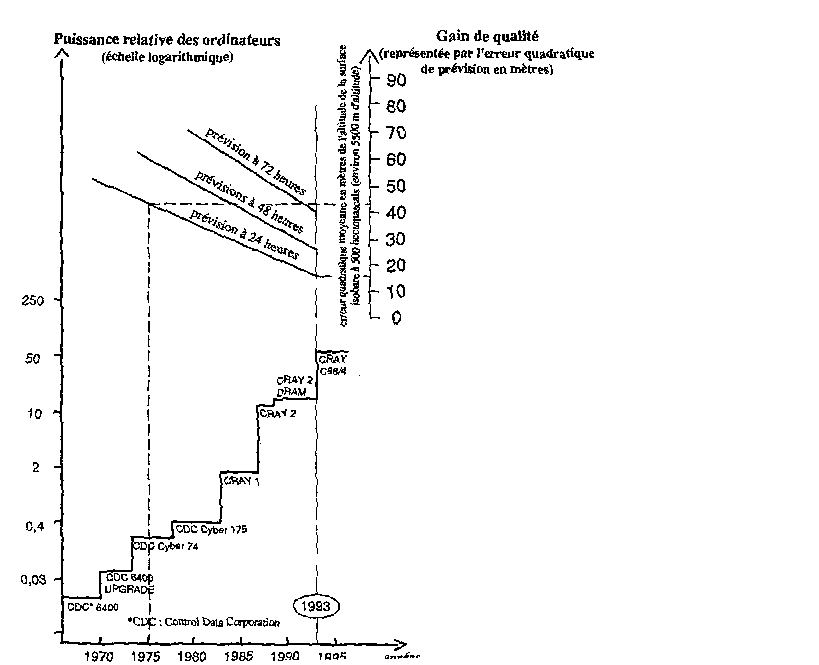

Prenons quelques exemples : la météorologie, la réalité virtuelle, la simulation numérique. Dans chaque cas, on sait bien à quoi occuper des croissnces en puissance encore considérables, la plus spectaculaire étant la simulation numérique.

On va continuer à donc manquer de ressources. Le logiciel peut toujours grandir. Pas de "maturité" à espérer dans le court terme (en encore moins dans le long terme, sans doute)

A titre personnel, comme d'entreprise, il faudra toujours arbitrer entre investissement et fonctionnement : quand acheter un nouveau micro, une nouvelle imprimante ? Quant prendre du temps pour mieux utiliser ce qu'on a ?

Depuis toujours, utilisateurs et informaticiens se font des reproches symétiques. Les informaticiens se plaignent de la résistance au changement, du manque de culture technique, de la mauvaise volonté des utilisateurs. Les utilisateurs se plaignent de la lenteur des machines, de la fiabilité limitée des systèmes, de la mauvaise volonté des informaticiens ou, derrière eux, des fournisseurs. Cela devrait aussi continuer.

Plus généralement, ces analyses appellent des études quantitatives. C'est précisément le rôle du groupe "Histoire quantitative de l'informatique" lancée par le Club de l'hypermonde. Il n'y a jamais de période de stabilité sur tous les fronts. Entre l'homme qui change peu et la loi de Moore qui est constante, il se fait des fronts, des blocages.

Intégration jusqu'où ?

Fusion du micro et de la TV ? Voix sur IP ? Accès combiné aux automates et aux personnes ?

Attention: espoirs de Métayer, de Kayak, d'IBM qui vient encore de lâcher une partie de ses activités réseau...

Tout s'unifie. Mais l'histoire nous apprend avec quelle lenteur. Parce que chaque unification oblige en fait à sauter des niveaux de complexité. A calculer dans des espaces à plus grand nombre de dimensions, à encadrer les données "utiles" par des préfixes, des typages de plus en plus volumineux, etc.

On espère toujours, et moi comme les autres vous l'avez vu, plus de simplicité dans l'avenir. Mais la réalité se charge toujours de ramener la complication. Ne serait-ce, parfois, que pour des raisons de compétitivité commerciale.

L'intelligence, jusqu'où ?

L'appétit peut être ici sans limite. Il y a bien sûr la reprise, jamais tout à fait abandonnées, des programmes de type "système expert".

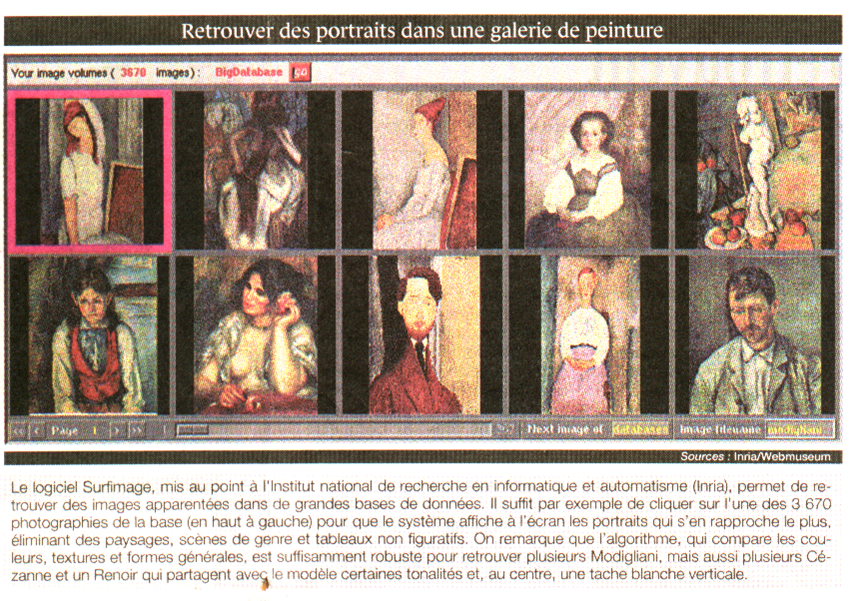

Il y a, de manière plus intuitivement perceptible, l'exploitation d'une information "non structurée". La compréhension du texte, des images. L'exploitation du "contenu" et non plus seulement du contenant. La recherche des signaux faibles dans la masse des signaux de toutes puissances, etc. Et le tout en temps réel si possible. Le rêve d'un ami: quand il arrive à un péage du RER, que la machine lui dise "Bonjour, monsieur Moch. Je sais que vous avez une carte intégrale. Passez, je vous en prie".

La parole, en particulier. Un vieux rêve. Il y avait déjà de la réponse vocale au Sicob de 1967. Elle reste aujourjourd'hui une application marginale. Pour des raisons techniques, mais aussi psychologiques. Le clavier a ses charmes ! Pourrait-on jouer une valse de Chopin avec un piano à commande vocale ?

Le mieux, pour dialoguer efficacement, serait que notre micro-ordinateur nous regarde, et comprenne ce que nous voulons sans que nous ayions à le lui dire ou à le taper au clavier. Si les logiciels d'IA deviennent très puissants, puisquoi Windows 2010 ne pourrait-il pas exploiter les images d'une webcam pour répondre plus vite à nos souhaits ? Un peu inquiétant, tout de même, mais...

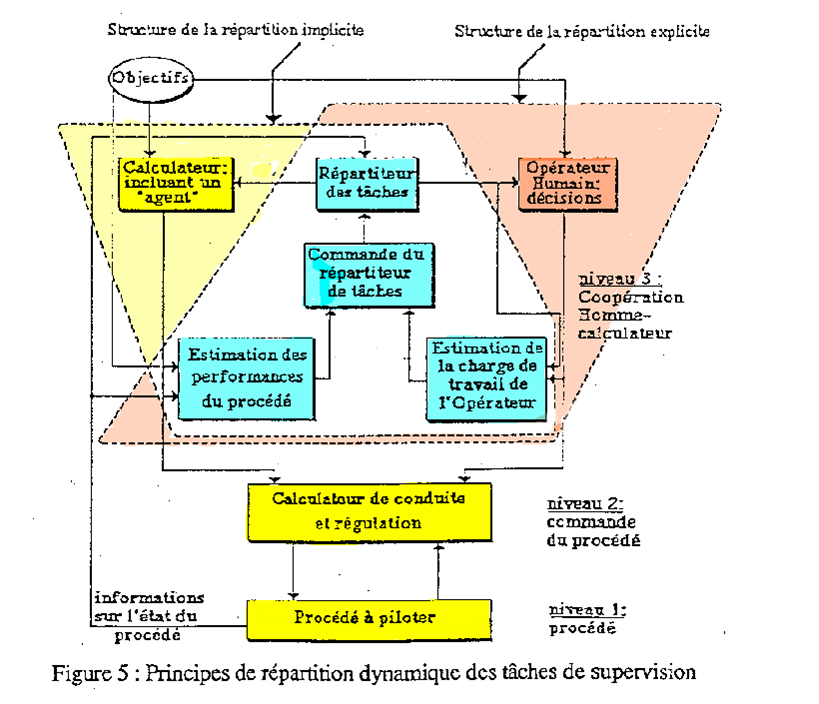

mais les travaus de l'université de Valenciennes montrent que, dans le travail, il faut tenir compte de la charge mentale de l'opérateur. Et que l'adaptation de la charge ne peut être laissée à l'appréciation de l'opérateur.

Les services, jusqu'où ?

Les services, on l'a vu, sont pratiquement aussi anciens que l'informatique. Suivant les périodes, les entreprises jouent au yo-yo avec les firmes de services. On l'a bien vu notamment dans le cas de la monétique. Tantôt les banques mutualisent pour explorer ce domaine à risques. Tantôt elles réintégrentc des activités qu'elles considérent comme lucratives ...

La mode de l'externalisation devrait durer. Elle rejoint en effet aussi des préoccupations techniques (mutulatisation de machines puissantes et de techniciens spécialisés) aussi bien que sociales... la meilleure manière de gérer les 35 heures, c'est de n'avoir que des fournisseurs à leur compte. Mais tout personne est-elle apte au travail indépendant ? Et l'atomisation de l'entreprise est-elle la panacée...

La limite du processus dépend pour une part non négligeable de l'évolution des outils et de leurs coûts, en particulier du coût des réseaux.

La productivité n'est jamais le seul argument pour informatiser. Parfois plutôt une contrainte qu'un objectif. Quant au client, on y a toujours pensé, sauf dans les périodes pénurie, où celui qui sait trouver de la matière première et des machines pour la travailler n'a pas de problème pour vendre.

Mais il prend maintenant une place toute particulière. Il faut le séduire, le retenir, "gagner son temps". Concrètement, cela s'exprime par la "guerre des portails". Une lutte technique pour les performances de l'accès. Une lutte sur les contenus. Une lutte sur les jeux d'ententes et de partenariats, pour que le portail donne accès au plus vaste bouquet de sevices possible.

Il faut en particulie qu'il intègre aussi bien l'accès à des personnes (centres d'appel, voix sur IP) qu'à des automates de plus en plus perfectionnés. Les analyses de Valenciennes sur le travailleur ont leur pendant dans le travail de marketing et d'ergonomie des portails. Ici encore, pas de limite à la puisance que l'on peut envisager d'affecter à cette conquète.

Le marché, jusqu'où ?

Aujourd'hui, l'économie américaine et européenne est en pleine forme, grâce aux nouvelles technologies. Le retournement de 1995 joue à plein.

Mais cette économie marche sur la tête. La capitalisation boursière les firmes en pointes se calcule en multipliant par mille ou dix mille... leurs pertes annuelles. Cela ne pourra pas durer toujours.

L'inégalité s'accroît, les écarts se creusent, dans chaque pays, et entre les pays du monde. Combien de temps, ou dans quelle proportion, pourra-t-on laisser jouer les règles du marché, régner la World Company ?

Les politiques sauront-ils mettre à profit les nouvelles technologies pour inventer de nouvelles formes de démocratie, de nouvelles formes d'intervention combinant la poursuite d'objectifs politiques et le respect des lois naturelles de l'économie ?

L'homme, jusqu'à quand ?

Et finalement, n'est-ce pas l'homme lui-même qui va finir par se trouver dépassé, déclassé, trop lent, à la rationalité trop limitée pour être longtemps un partenaire valable dans un monde de machines qui, de plus en plus, communiquent entre elles bien plus qu'avec les être humains ?

Rassurons-nous : les experts qui avancent des dates pour ce dépassement radical de l'homme parlent nous laissent tous une cinquantaine d'années. Il n'empêche que, biologie et informatique de conjuguant, le problème d'un "post humanisme" peut se poser, et retiendra l'attention du Club de l'hypersomnie pendant le prochain semestre.

Rien n'oblige à voir cette perspective de manière pessimiste, bien au contraire. Si le retournement de 1995 se confirme, l'ouverture de nouveaux espaces par les nouvelles technologies est si vaste que, entre humains et post-humains, les occasions de partenariats et de win-win domineront largement les points de friction.

Rêvons. Sur le Luxembourg, le soleil se couche. Le ciel est rouge...

Mourad Abed Thèse 1990

Mourad Abed Thèse 1990